Hallucineren

Wat als GenAI je vertelt dat Einstein een talentvol breakdancer was, dat er pinguïns wonen in de Sahara, dat Napoleon een wereldrecord in skateboarden heeft gevestigd of dat buitenaardse wezens een reuzen-Rubik’s kubus op de maan achterlieten? Dat klinkt misschien lachwekkend, maar zulke vreemde en onjuiste antwoorden zijn precies wat er kan gebeuren als GenAI hallucineert: het bedenkt informatie die nergens op slaat, maar toch verrassend overtuigend klinkt. Hallucinaties ontstaan vaak door de manier waarop GenAI getraind is. Het systeem baseert zijn antwoorden op grote hoeveelheden data, maar het begrijpt niet echt wat het zegt. Soms maakt het verkeerde verbindingen en creëert het daardoor valse informatie.

Een voorbeeld van een dergelijke AI-hallucinatie gebeurde in 2023, toen een AI-assistent juridische uitspraken verzon die nooit hadden plaatsgevonden. Een advocaat gebruikte de valse informatie in een zaak, wat leidde tot ernstige complicaties en reputatieschade. Het toont aan hoe belangrijk het is om informatie altijd te verifiëren, zelfs als die afkomstig is van een geavanceerd AI-systeem. Toegegeven, GenAI kan indrukwekkend zijn, maar het is geen onfeilbare bron van waarheid. Blijf alert en gebruik je gezond verstand wanneer je omgaat met AI-gegenereerde informatie.

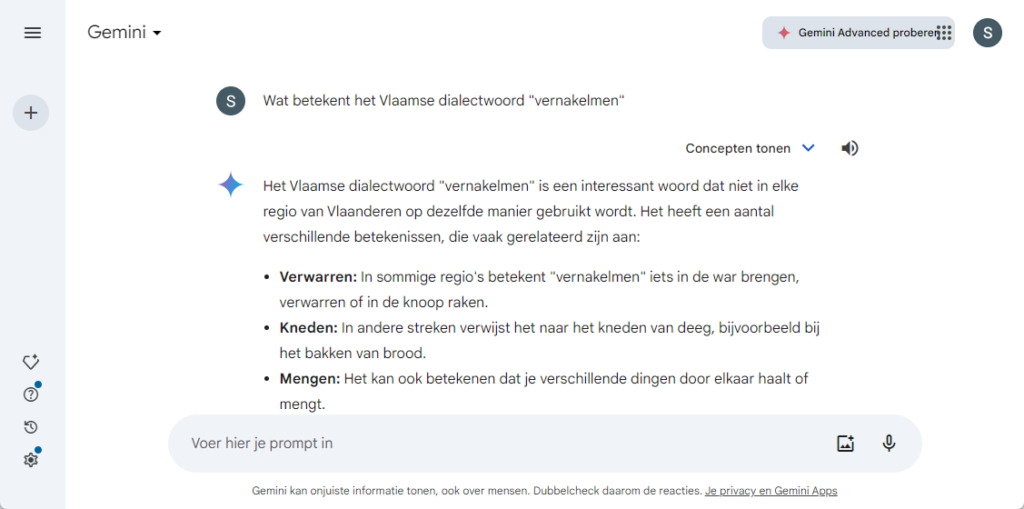

Wanneer we aan Gemini vroegen een verzonnen dialectwoord te verklaren, kregen we deze verrassende hallucinatie als antwoord:

Verzin zelf een nieuw dialectwoord en vraag aan ChatGPT of een ander LLM naar keuze wat de betekenis van je woord is.

Benader GenAI altijd met een kritisch oog, vooral wanneer iets ongewoon of ongelooflijk klinkt. Hoewel AI-technologie verbluffend realistische beelden kan creëren, kan het ook misleidend zijn. Het is belangrijk om alert te zijn voor kleine onregelmatigheden en om informatie te verifiëren zodat je zelf niet in de val van een AI-hallucinatie trapt.